Как преступники могут использовать искусственный интеллект? Самый опасный вариант

Последние 10 лет мы ежедневно слышим новости про то, как тот или иной искусственный интеллект научился новым навыкам. На сегодняшний день компьютерные алгоритмы умеют копировать стили рисования известных художников, имитировать чужие голоса, создавать поддельные видеоролики с публичными личностями и многое другое. За всем этим очень интересно следить, но многие эксперты по компьютерной безопасности обеспокоены тем, что разрабатываемые технологии могут использоваться злоумышленниками для совершения преступлений. Ведь использование нейронных сетей для осуществления каких-либо задач на данный момент никак не регулируется. Получается, что любой человек, хорошо владеющий программированием, может использовать искусственный интеллект для выманивания у людей денег, слежки и совершения прочих противозаконных действий. Недавно сотрудники Университетского колледжа Лондона решили выяснить, какое именно умение искусственного интеллекта может нанести человеческому обществу наибольший вред.

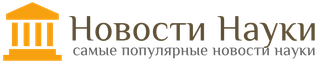

Искусственный интеллект способен на многое. Например, он может заменить лицо Арнольда Шварценеггера на Сильвестра Сталлоне

Искусственный интеллект — свойство компьютеров выполнять творческие функции, которые больше свойственны реальным людям. На нашем сайте есть специальный раздел, посвященный этой теме.

Возможности искусственного интеллекта

Результатами проделанной работы поделилось издание The Next Web. В рамках научной работы исследователи определили 20 умений искусственного интеллекта, которые будут доступны преступникам в следующие 15 лет. К сожалению, полный список методов использования не удалось найти даже на сайте колледжа, но исследователи все же упомянули самые важные пункты.

Итак, по их мнению, искусственный интеллект умеет:

- управлять электрическими автомобилями, что больше известно как автопилот;

- обманным путем узнавать логины, пароли и прочие личные данные пользователей — иначе говоря, заниматься фишингом;

- собирать компрометирующие фото, видео и прочие данные о людях, которые могут быть использованы для шантажа;

- генерировать фальшивые новости, при помощи которых можно управлять мышлением большого количества людей;

- управлять роботами, при помощи которых можно следить за людьми и даже грабить дома;

- создавать поддельные видеоролики с известными людьми, чтобы испортить их репутацию.

Эти и многие другие способы использования нейронных сетей в преступных целях были изучены группой из 31 эксперта по искусственному интеллекту. Перед ними была поставлена задача отсортировать все этим умения по уровню опасности для общества. При составлении рейтинга эксперты учитывали сложность использования искусственного интеллекта для выполнения тех или иных задач, возможность предотвращения мошенничества и количество денег, которые преступники могут получить обманным путем.

Читайте также: Почему мы верим фейковым новостям?

Опасность нейросетей

Самой опасной способностью искусственного интеллекта было названо создание так называемых дипфейков (deepfakes). Впервые об этом умении компьютерных алгоритмов стало известно примерно в 2017 году. Именно тогда один из пользователей сайта Reddit показал миру, как имея мощный компьютер можно создать фальшивое видео, где лицо одного человека человека заменено на другое. Он продемонстрировал это на самом непристойном примере, вставив лица известных людей в видео для взрослых. Эта новость навела очень много шума и дипфейки в таком виде даже стали запрещены. Однако, на данный момент никто не мешает программистам создавать забавные видео наподобие того, где Илон Маск поет песню про «рокот космодрома».

Создание фальшивых видео было признано опасной функцией по двум причинам.

Во-первых, при помощи них можно как выманивать деньги, так и портить репутацию людей. Вот небольшой пример. На данный момент, с целью получения легких денег многие мошенники взламывают аккаунты людей в социальных сетях и просят их близких друзей перечислить им определенную сумму денег. Объяснением причин они особо не занимаются и уходят от такого разговора словами, мол, «сейчас некогда, потом объясню». Примерно пять лет назад эта схема была рабочей и многие люди действительно выручали «близких друзей». Но теперь на такие уловки мало кто клюет. Однако, если мошенники создадут дипфейк на основе аватарки пользователя и отправят его друзьям видео, на котором он якобы на камеру просит отправить деньги, многие люди всерьез обеспокоятся и поверят мошенникам.

Иногда фальшивое видео действительно трудно отличить от оригинала

Также дипфейки могут использоваться для порчи репутации известных людей и это было доказано много раз. Вот уже несколько лет подряд в Интернете возникают видео с якобы пьяной Нэнси Пелоси — спикера Палаты представителей США. Разумеется, эти видео поддельные, но они набирают много просмотров и некоторые люди действительно могут принять их за настоящие. Ведь о технологии создания поддельных видео многие даже не подозревают — из представителей старшего поколения технологически подкованных людей вообще единицы.

Об опасности нейросетей ранее писал мой коллега Артем Сутягин. Получился очень подробный материал, поэтому настоятельно советую к прочтению!

Вторая опасность заключается в том, что такой метод мошенничества трудно остановить. Дело в том, что фальшивые видео получаются настолько реалистичными, что распознать их практически невозможно. В июне 2020 года это было доказано в рамках проведенного компанией Facebook конкурса Deepfake Detection Challenge. В нем приняло участие более 2000 разработчиков, которые создавали алгоритмы распознавания поддельных видеороликов. Самая высокая точность распознавания составила 65% что, по мнению экспертов по кибербезопасности, в настолько серьезном деле очень плохой результат.

Раздел сайта Reddit, где публиковались дипфейки, уже заблокирован

Борьба с преступностью

Другие функции искусственного интеллекта вроде управления автомобилями и роботами не считаются настолько опасными, как дипфейки. Да, взломанный автопилот может заставить автомобиль свернуть с пути и на большой скорости врезаться в столб. Но это в этом случае речь идет об одной жертве, тогда как фальшивые видео могут повлиять на разум тысяч людей. Ну или, взять, к примеру, использование роботов для слежки за людьми и совершения ограблений домов. Эксперты вообще не видят в них опасности, потому что их очень легко обнаружить. Молоток в руки и все — «шпиона» как не бывало.

Если вам нравятся наши статьи, подпишитесь на нас в Google News! Так вам будет удобнее следить за новыми материалами.

Что делать, чтобы свести к минимуму опасность от искусственного интеллекта, пока не ясно. Как вариант, можно продолжить работу над созданием алгоритма выявления фейковых видеороликов. Также можно каким-то образом контролировать использование нейросетей, но это может затормозить развитие технологий. Ведь искусственный интеллект используется не только преступниками, но и учеными, которые хотят сделать мир лучше. Недавно стартап Landing AI научил его следить за соблюдением социальной дистанции, что в наше непростое время может спасти множество жизней.